对于新站长来说,可能并不一定知道robots.txt这个文件是干什么用的。所以更不知道robots.txt跟网站SEO之间有什么关系。

今天建站笔记就给大家分享一下如何正确编写robots.txt文件来助力网站SEO。

什么是robots.txt

robots.txt又叫做robots协议,是国际互联网界通行的道德规范。

robots.txt是一个文本文件,位于你网站的根目录,用来告知搜索引擎哪些页面能被抓取,哪些页面不能被抓取;可以屏蔽一些网站中比较大的文件,如:图片,音乐,视频等,节省服务器带宽;可以屏蔽站点的一些死链接。方便搜索引擎抓取网站内容;设置网站地图连接,方便引导蜘蛛爬取页面。

怎么创建robots.txt文件

你只需要用文本编辑软件,例如记事本,创建一个文件名为robots.txt的文本文件,然后把这个文件上传到网站根目录就算创建好了。

怎么写robots.txt规则

单独创建robots.txt文件是不够的,精髓在于编写合适自己网站的robots规则。

robots.txt支持下面这些规则

User-agent: * 这里的*代表的所有的搜索引擎种类,*是一个通配符 Disallow: /admin/ 这里定义是禁止爬寻admin目录下面的目录 Disallow: /require/ 这里定义是禁止爬寻require目录下面的目录 Disallow: /ABC/ 这里定义是禁止爬寻ABC目录下面的目录 Disallow: /cgi-bin/*.htm 禁止访问/cgi-bin/目录下的所有以".htm"为后缀的URL(包含子目录)。 Disallow: /*?* 禁止访问网站中所有包含问号 (?) 的网址 Disallow: /.jpg$ 禁止抓取网页所有的.jpg格式的图片 Disallow:/ab/adc.html 禁止爬取ab文件夹下面的adc.html文件。 Allow: /cgi-bin/ 这里定义是允许爬寻cgi-bin目录下面的目录 Allow: /tmp 这里定义是允许爬寻tmp的整个目录 Allow: .htm$ 仅允许访问以".htm"为后缀的URL。 Allow: .gif$ 允许抓取网页和gif格式图片 Sitemap: 网站地图 告诉爬虫这个页面是网站地图

这里推荐大家使用站长工具的robots生成工具来编写规则会更加简单明了。

WordPress的robots.txt规则推荐

wordpress安装完毕后,默认会虚拟一个robots.txt规则文件(也就是说你在网站目录里面看不到,但是可以通过“网址/robots.txt”访问)

默认规则如下:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

这条规则的意思是,所有搜索引擎,禁止抓取wp-admin文件夹下面的内容,但是准许抓取/wp-admin/admin-ajax.php这个文件。

但是出于网站SEO和安全方面的考虑,奶爸建议将规则更加完善一下,下面是建站笔记目前的robots.txt规则。

User-agent: * Disallow: /wp-admin/ Disallow: /wp-content/plugins/ Disallow: /?s=* Allow: /wp-admin/admin-ajax.php User-agent: YandexBot Disallow: / User-agent: DotBot Disallow: / User-agent: BLEXBot Disallow: / User-agent: YaK Disallow: / Sitemap: https://blog.naibabiji.com/sitemap_index.xml

上面的规则在默认规则上面添加了下面两行:

Disallow: /wp-content/plugins/ Disallow: /?s=*

禁止抓取/wp-content/plugins/文件夹和网址为/?s=*的网页。

/wp-content/plugins/是WordPress插件目录,避免被抓取出现隐私风险(例如某些插件有隐私泄露的bug,正好被搜索引擎抓取到了。)

禁止抓取搜索结果页,避免被别人用来刷权重:

网址为/?s=*的网页,这个也是最近奶爸刚发现的一个被SEO灰产项目利用的bug。

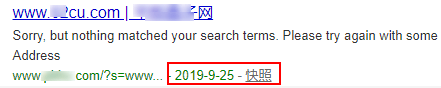

/?s=*的网址是WordPress网站的默认搜索结果页面,如下图:

基本上绝大多数的WordPress主题搜索页面的标题都是“关键字+网站标题”组合的形式。

但是这个就会出现一个问题,那就是百度有机率抓取到这种网页。例如有个站就很不辛被人利用了。

后面几条规则是禁止特定搜索引擎抓取规则和一个sitemap地址链接,就不用过多介绍了。

怎么检测robots.txt是否生效

创建并且写好robots.txt规则后,可以使用百度站长的robots检测工具来判断是否生效。

不过百度的不支持https的网站进行检测,可以使用爱站的工具。

暂无评论内容